微软论文曝光:GPT-3.5仅有200亿参数?网友惊呼离谱!

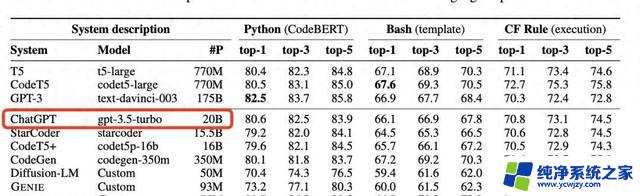

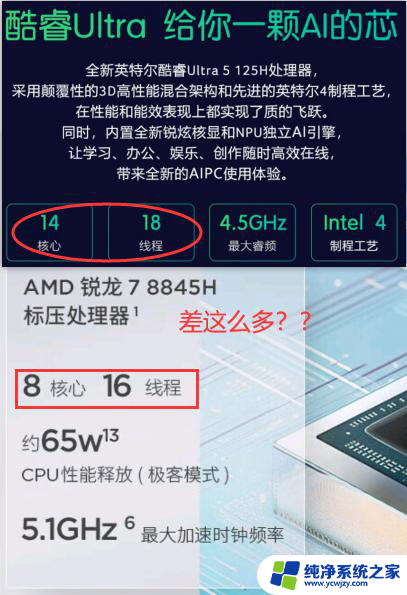

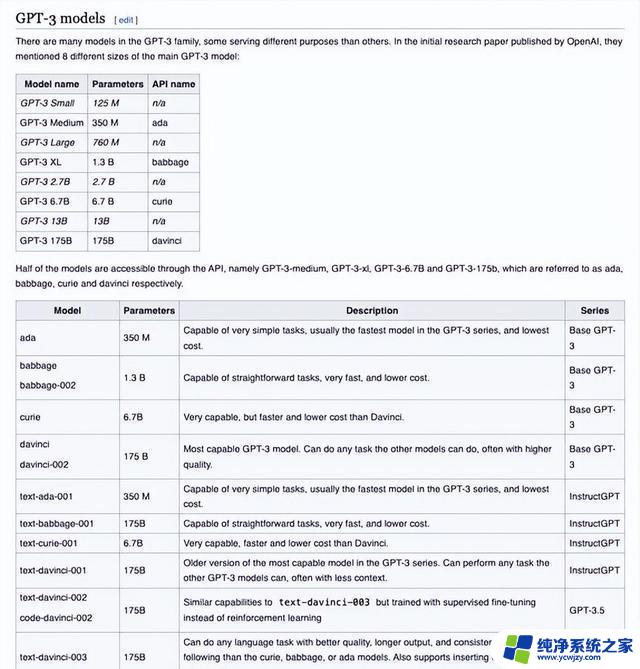

最近,微软发布了一篇引起广泛关注和讨论的论文。这篇论文中提到了一个名为GPT35的模型,其参数量仅为20B。这个消息打破了之前大家对于GPT35参数量的猜测,因为人们普遍认为它应该是175B。

对于这个意外之举,网友们纷纷发表评论和观点。有些人表示惊讶和好奇,怀疑微软是否在隐藏某些信息或者技术突破。还有一些人则质疑GPT35模型的性能是否会受到影响,并担心它无法达到预期效果。

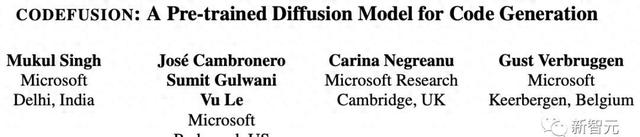

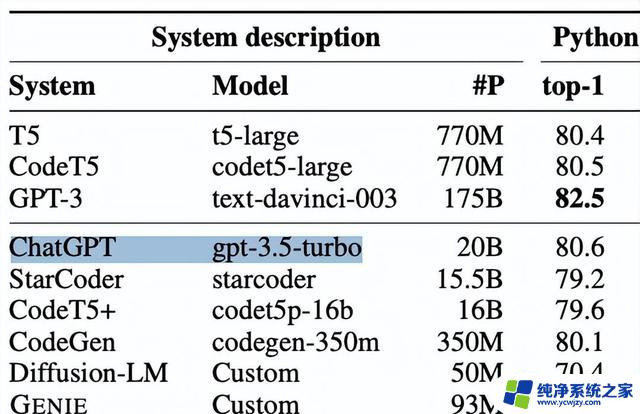

除了GPT35之外,在同一份论文中还介绍了微软发布的另一个模型CodeFusion。与更大规模的模型相比,CodeFusion在代码生成任务方面表现出色。并且具备相当高水平的性能。

CodeFusion模型经过两个阶段进行训练,并通过引入噪声来提升其性能。这种方法使得CodeFusion不仅可以生成高质量代码,而且具备较强鲁棒性和适应性。

然而,在文章结尾处作者也提出了一系列问题:究竟GPT35的真实参数量是多少?GPT4与GPT35之间是否存在某种联系?这些问题需要等到真正开源时才能得到答案。

总的来说,微软最近发布的论文引起了广泛关注。无论是GPT35模型的参数量还是CodeFusion模型在代码生成任务中的性能都给人们带来了新鲜感和好奇心。然而,对于一些未解之谜,我们只能静待开源揭晓答案。