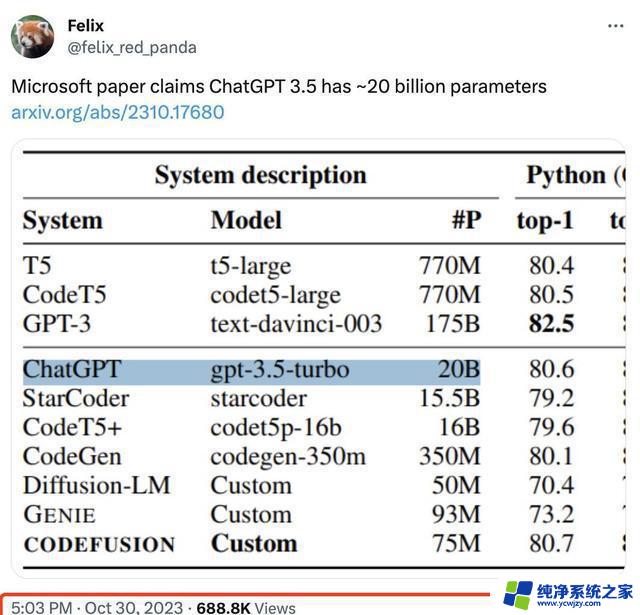

ChatGPT真实参数曝光!微软首次披露200亿规模,引发网友猜测:是否要开源?

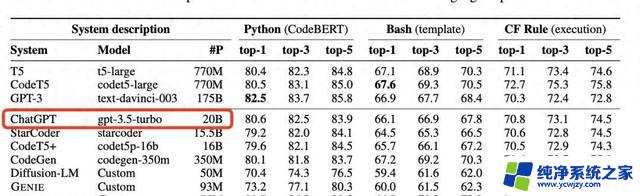

引发轰动的小巨人那么,这200亿参数的ChatGPT,究竟隐含了怎样的力量?微软的一份论文无意中泄露了这一信息,不禁让人遐想:在大模型盛行的今天,是否“大”才是“美”的唯一标准?ChatGPT的表现,似乎在否定这一旧观念。

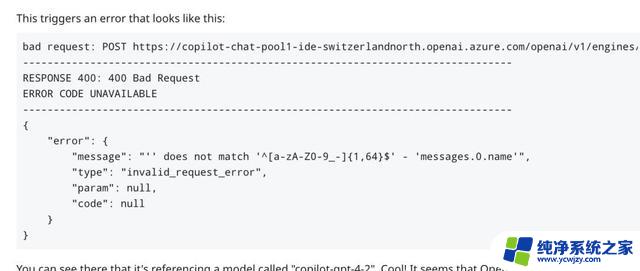

疑问与猜想社交平台上,对这一发现的质疑声不断。这是否只是一个简单的拼写错误,或者OpenAI即将开源的一个迹象?疑惑中,GitHub Copilot的API中又出现了所谓的GPT-4的新型号,引人深思。

突破性研究:深度扩散微软的这篇论文,不仅因为其揭示的秘密引起轩然大波,其本身也具有研究价值。它首次使用扩散模型来进行代码生成,带来了对现有AI模型架构的重要补充。

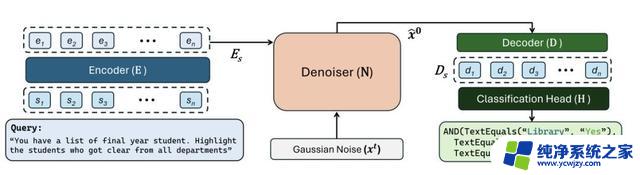

编码器和解码器的优雅舞步研究中提出的CODEFUSION,是一种结合了编码器、解码器和去噪器的架构。它将自然语言的输入转化为连续的表示形式,然后迭代去除高斯噪声,以生成准确的代码tokens。

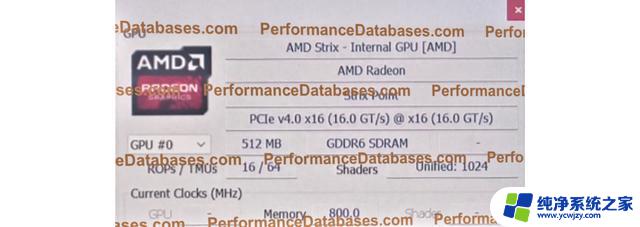

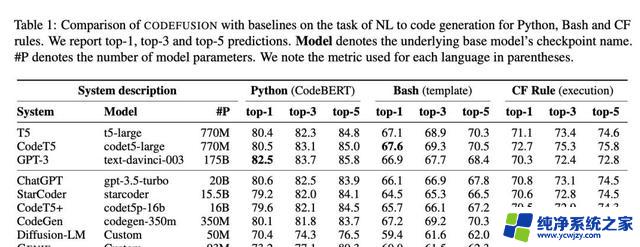

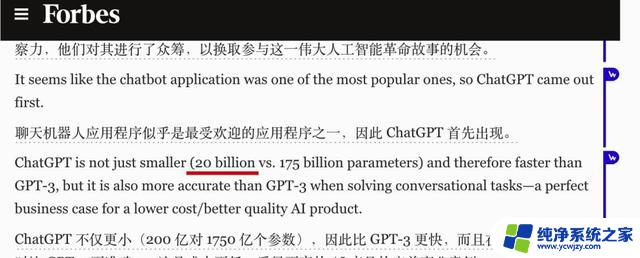

小巨人的惊人实力在Python、Bash和Excel CF规则三个任务的评估中,仅有7500万参数的CODEFUSION展现了与200亿参数的GPT-3.5-turbo相近的性能,甚至在代码的多样性上有了更好的表现。

多样性与准确性的平衡艺术CODEFUSION在生成语法正确的代码方面,比纯文本生成的diffusion模型做得更好。与自回归模型相比,它生成的代码候选项更为多样化。在准确率的竞赛中,CODEFUSION在多样性与质量间取得了平衡,显示了其独到的优势。

巨流中的一石激起千层浪本来是一次正常的性能比较,却因为揭示了ChatGPT的参数量而意外成为焦点。有人甚至开始猜测,这是否是OpenAI开源大模型的前奏。

预兆与揭示值得注意的是,早在今年2月,福布斯的一则报道就已透露了ChatGPT的参数量。当时这个消息并未引起太大的关注,直到如今这个统计图的出现。

结语:AI领域的新探索一张简单的图表,一篇深刻的论文,不仅揭开了AI界的一个小秘密,也让我们对大模型有了新的认识。在AI的发展道路上,或许我们不应只追求规模的增长。更应关注如何优雅地编织这些复杂的算法,使它们即使在参数上不占优势时,也能展现出惊人的能力。这正是科技进步的魅力所在——总有意想不到的惊喜等待着我们去探索。

新时代的AI奇迹:小巨人的潜力在人工智能领域,ChatGPT的参数数量仅为200亿,却引发了巨大的关注。这引发了人们对大型模型是否是唯一标准的质疑。或许现在的趋势是朝着更小、更高效的模型发展,而不再是无休止地追求参数数量的增加。这一新发现让我们重新思考AI模型的优越性,可能将带来更多关于模型规模与性能的探讨。

疑问与猜想社交平台上出现了关于这一发现的质疑声,一些人认为这可能只是一个拼写错误或OpenAI即将开源一个新模型的迹象。GitHub Copilot的API也提到了一个新型号的GPT-4,这进一步引发了猜测。这些疑问和猜想激发了对AI领域未来的更多探讨,人们开始猜测是否会有更多类似的小型模型涌现。

突破性研究微软的论文不仅揭示了ChatGPT的参数数量,还提出了CODEFUSION,一种结合了编码器、解码器和去噪器的架构,用于代码生成。这一研究为AI模型架构带来了重要的补充,尤其是在代码生成领域。CODEFUSION在准确性和多样性之间找到了平衡,表现出独特的优势,这可能引领未来AI研究的新方向。

突破性研究微软的论文不仅揭示了ChatGPT的参数数量,还提出了CODEFUSION,一种结合了编码器、解码器和去噪器的架构,用于代码生成。这一研究为AI模型架构带来了重要的补充,尤其是在代码生成领域。CODEFUSION在准确性和多样性之间找到了平衡,表现出独特的优势,这可能引领未来AI研究的新方向。